Cảnh giác với Rủi ro Bảo mật từ DeepSeek và AI Mở

Nếu bạn theo dõi tin tức công nghệ gần đây, có thể bạn đã nghe đến DeepSeek – một mô hình ngôn ngữ lớn (LLM) đang tạo ra sự xáo trộn trên thị trường AI. Được phát triển bởi một startup Trung Quốc với 200 nhân sự, DeepSeek có khả năng sánh ngang với những công cụ tiên tiến từ OpenAI hay Google, nhưng lại có lợi thế về tốc độ và chi phí vận hành thấp hơn đáng kể.

Đáng chú ý, DeepSeek được phát hành dưới dạng mã nguồn mở và có thể chạy trên phần cứng phổ thông, cho phép bất kỳ nhà phát triển nào tiếp cận mà không cần đầu tư vào GPU đắt đỏ. DeepSeek đã được ca ngợi là “Khủng hoảng Sputnik” cho AI và đã gây chấn động khắp thị trường tài chính. Tuy nhiên, chính đặc tính mở và dễ tiếp cận này lại làm dấy lên những lo ngại nghiêm trọng về bảo mật.

Những Lỗ Hổng Bảo Mật Đáng Báo Động

Các chuyên gia từ Palo Alto Networks Unit 42 đã phát hiện ra nhiều lỗ hổng bảo mật trong DeepSeek, cho phép dễ dàng vượt qua các cơ chế kiểm soát và tạo ra nội dung độc hại mà không đòi hỏi kiến thức chuyên sâu. Họ đã thử nghiệm ba kỹ thuật tấn công nâng cao – Deceptive Delight, Bad Likert Judge và Crescendo – và ghi nhận tỷ lệ vượt qua rào chắn bảo mật cao đáng báo động. Những lỗ hổng này có thể bị khai thác để thực hiện các hoạt động nguy hiểm như:

- Tạo phần mềm gián điệp (keylogger)

- Rò rỉ dữ liệu (data exfiltration)

- Hướng dẫn chế tạo thiết bị nguy hiểm

Những phát hiện này nhấn mạnh rằng các mô hình AI mở có thể trở thành mục tiêu bị khai thác bởi tội phạm mạng, gây rủi ro lớn cho doanh nghiệp.

Bài Học Cho Các Nhà Lãnh Đạo An Ninh

Sự xuất hiện của DeepSeek cho thấy tốc độ phát triển AI là không thể đoán trước. Một mô hình ít được biết đến có thể nhanh chóng trở thành tâm điểm chỉ sau vài ngày, với hàng trăm phiên bản phái sinh xuất hiện trên các nền tảng như Hugging Face. Điều này đặt ra thách thức lớn cho các doanh nghiệp trong việc kiểm soát và bảo vệ hệ thống trước các mô hình AI mới.

Doanh nghiệp cần thận trọng trong việc áp dụng các mô hình AI, vì chỉ với một vài dòng mã, họ có thể thay đổi mô hình nền tảng từ OpenAI, Google sang DeepSeek hoặc bất kỳ mô hình nào khác. Điều này làm gia tăng rủi ro bảo mật nếu không có biện pháp kiểm soát chặt chẽ.

Chiến Lược Bảo Mật AI Hiệu Quả

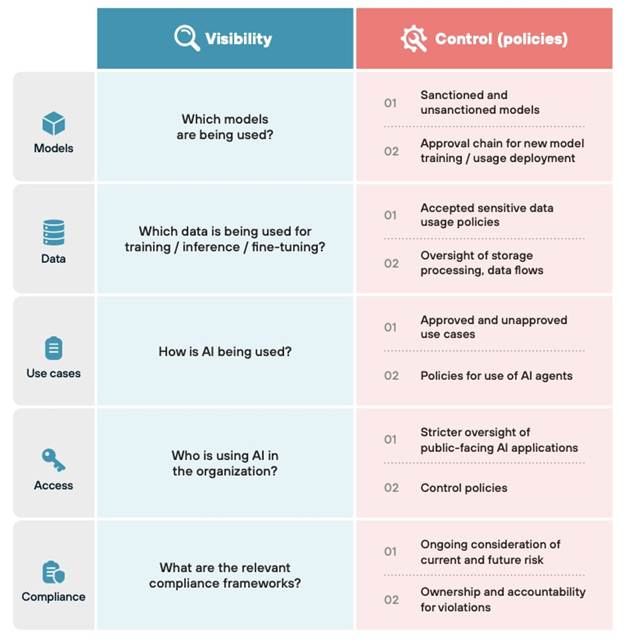

Mặc dù không thể ngăn chặn hoàn toàn mọi cuộc tấn công vào AI, doanh nghiệp có thể triển khai các biện pháp bảo mật để giám sát và kiểm soát việc sử dụng LLMs, đặc biệt là các mô hình AI bên thứ ba chưa được phê duyệt.

🔹 AI Access Security giúp giám sát và kiểm soát việc sử dụng AI trong tổ chức:

✔ Theo dõi theo thời gian thực về những ứng dụng GenAI đang được sử dụng trên toàn tổ chức và bởi ai.

✔ Kiểm soát truy cập, chặn các ứng dụng không được phê duyệt, áp dụng các chính sách InfoSec và bảo vệ chống lại các mối đe dọa.

✔ Bảo vệ dữ liệu nhạy cảm khỏi bị truy cập trái phép và rò rỉ vào các ứng dụng GenAI và mô hình đào tạo AI có rủi ro.

🔹 Xây dựng AI Runtime Security và AI-SPM bảo vệ ứng dụng AI nội bộ của doanh nghiệp:

✔ Bảo vệ các ứng dụng và mô hình khỏi các rủi ro về chuỗi cung ứng, cấu hình và thời gian chạy cho tất cả các ứng dụng và mô hình AI.

✔ Bảo vệ dữ liệu trong các ứng dụng và mô hình khỏi bị rò rỉ, cho dù là do hành động cố ý hay vô tình.

4 Bước Giảm Thiểu Rủi Ro Khi Sử Dụng AI Mới

1️– Xây dựng cơ chế giám sát tập trung đối với việc sử dụng AI trong tổ chức: Việc kiểm soát theo từng mô hình AI riêng lẻ là không khả thi. Doanh nghiệp nên thiết lập khả năng giám sát toàn diện trên nhiều nền tảng đám mây và trong toàn tổ chức, giúp theo dõi kho mô hình hiện có và phát hiện khi có mô hình mới được triển khai.

2️– Thiết lập chính sách rõ ràng về AI được phép và không được phép sử dụng: Mỗi tổ chức sẽ có mức độ chấp nhận rủi ro khác nhau đối với công nghệ mới, nhưng không nên ra quyết định theo kiểu ngẫu hứng, cảm tính. Một quy trình bài bản để kiểm tra, đánh giá và phê duyệt các mô hình mới sẽ giúp doanh nghiệp kiểm soát tốt hơn các rủi ro tiềm ẩn.

3️– Xác định biện pháp bảo vệ phù hợp cho mô hình AI trong môi trường vận hành: Câu hỏi về mức độ chấp nhận rủi ro vẫn luôn tồn tại, nhưng quyết định cần được đưa ra từ trước. Các biện pháp bảo vệ có thể được áp dụng đối với cả đầu vào và đầu ra của mô hình. Công cụ AI Runtime Security cho phép giám sát và chặn các mối đe dọa liên quan đến AI như lừa đảo qua prompt injection, URL độc hại và rò rỉ dữ liệu không an toàn.

4️– Giảm thiểu nguy cơ rò rỉ dữ liệu: Khi mô hình AI có quyền truy cập vào dữ liệu nhạy cảm (dù để huấn luyện hay suy luận), rủi ro mất an toàn thông tin sẽ tăng cao. Việc áp dụng một cách tiếp cận bảo mật thống nhất – giúp cung cấp cái nhìn toàn diện về dữ liệu, các đường tấn công tiềm ẩn, mã nguồn và ứng dụng – sẽ giúp doanh nghiệp xác định được điểm yếu. AI Runtime Security có thể phát hiện hàng nghìn mẫu dữ liệu nhạy cảm được định nghĩa trước, giúp ngăn chặn nguy cơ rò rỉ dữ liệu do lỗi vô ý hoặc hành vi cố ý.

Cảnh Báo Quan Trọng

DeepSeek là một lời cảnh báo rằng AI mã nguồn mở có thể tạo ra cả cơ hội lẫn rủi ro nghiêm trọng. Nếu tổ chức của bạn chưa có chiến lược bảo mật AI, đây là lúc cần hành động.